Don’t trust the algorithm

di Cristina Cavicchini e Matilde Rafanelli

Non possiamo più considerare l’algoritmo come qualcosa di “altro da noi”; se finora siamo riusciti a definirlo vagamente come tecnica computazionale alla base dell’IA, mirata alla riproduzione dei comportamenti umani, oggi dobbiamo fare i conti con un altro tipo di realtà. L’algoritmo è diventato tangibile, invadente. Ce ne siamo resi conto da quando espressioni come data mining, machine learning, lavoro digitale, data privacy sono entrati a far parte del nostro linguaggio quotidiano. Già nel 2017  Nick Srnicek si chiedeva dove ci avrebbe portati la nuova tecnologia, e a quali conseguenze sarebbe andata in contro la società del capitalismo digitale. L’era di trasformazione era vista come qualcosa di potenzialmente positivo, ma viziata dal capitalismo. Si parlava di condivisione, flessibilità, imprenditorialità, liberazione dei lavoratori dalle costrizioni e dalle gerarchie, interconnessione e on-demand per i consumatori. O, almeno, questo era quello che ci si aspettava in una visione ottimistica, perché tutto ciò nasceva dentro una logica di generazione di profitti ed ampliamento della concorrenza tipica del capitalismo.

Nick Srnicek si chiedeva dove ci avrebbe portati la nuova tecnologia, e a quali conseguenze sarebbe andata in contro la società del capitalismo digitale. L’era di trasformazione era vista come qualcosa di potenzialmente positivo, ma viziata dal capitalismo. Si parlava di condivisione, flessibilità, imprenditorialità, liberazione dei lavoratori dalle costrizioni e dalle gerarchie, interconnessione e on-demand per i consumatori. O, almeno, questo era quello che ci si aspettava in una visione ottimistica, perché tutto ciò nasceva dentro una logica di generazione di profitti ed ampliamento della concorrenza tipica del capitalismo.

A causa di un lungo declino della redditività del settore manifatturiero, il capitalismo ha iniziato a occuparsi dei dati come un mezzo per mantenere crescita economica e vitalità in presenza di un settore produttivo altrimenti pigro. I dati, cioè, hanno assunto un ruolo sempre più centrale per le aziende.

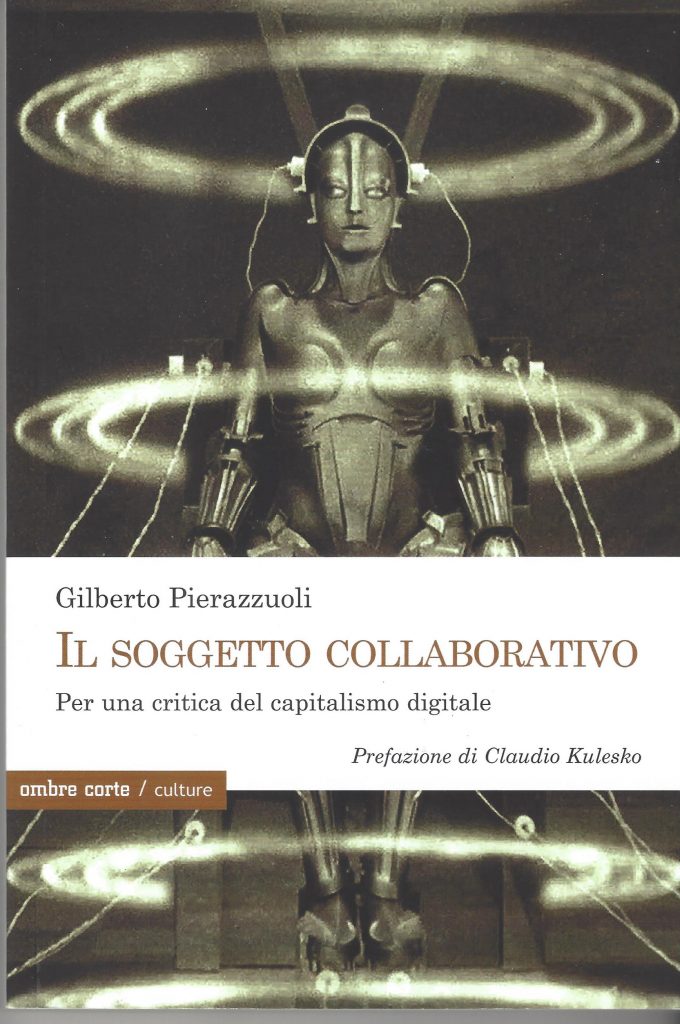

Nel libro Il soggetto collaborativo – Per una critica del capitalismo digitale, Gilberto Pierazzuoli sottolinea proprio questo potere estrattivo delle piattaforme, ponendo l’accento sul disagio a cui sono poi costretti gli utenti, secondo il principio per cui niente è e sarà mai gratuito in una società orientata al profitto. In preda o all’entusiasmo da “infatuazione digitale” o all’indifferenza, siamo rimasti distratti mentre Google e Facebook si appropriavano di enormi quantità di informazioni tramite la personalizzazione delle ricerche, captcha, cookie, news feed.

“Google è stato multato per una cifra record. Al centro delle contestazioni da parte dell’Antitrust europeo, la promozione del suo servizio Google Shopping a scapito delle logiche di concorrenza. Nel 2015, infatti, al termine della conclusione dell’indagine preliminare, la Commissione aveva stabilito che Google favoriva sistematicamente il proprio prodotto per gli acquisti comparativi (Google Shopping) nelle sue pagine generali che mostrano i risultati delle ricerche, deviando il traffico da servizi di acquisto comparativo concorrenti”[1].

Richiamando anche l’episodio di Cambridge Analytica, l’autore continua il dibattito secondo cui l’estrazione dei dati non ha come fine ultimo solo quello di offrire una pubblicità perfettamente mirata, ma utilizza quest’ultima per prevedere il nostro comportamento. L’algoritmo ci conoscerà in maniera così “intima” che saprà anche come condizionarci.

Siamo quindi dinnanzi ad una società del controllo? Aveva ragione Orwell, oppure siamo tenuti ad osservare e comprendere quella zona grigia che divide i tecnofobi dai tecnofili?

Evgeny Morozov, studioso bielorusso, uno dei primi e più coerenti critici della cultura della

Silicon Valley, ci aveva avvertito: la rete è una delusione, i governi autoritari la stanno usando per fini di censura, controllo e propaganda. Al contrario di quanto si tende a pensare, la rete potrebbe rivelarsi un potente mezzo in mano alle autocrazie.

Russia, Cina, Arabia Saudita, ma anche Egitto, Tunisia e Siria, fanno un uso autoritario della rete, ne filtrano l’informazione, ne sorvegliano le comunicazioni, la piegano a proprio beneficio per costruire consenso. Questo è tutto quello che pensavamo di sapere. Dal 2013, con le rivelazioni del whistleblower Edward Snowden, abbiamo la certezza che non soltanto i governi autoritari, ma anche quelli democratici come gli Stati Uniti controllino, sorveglino e spianino le comunicazioni globali.

Russia, Cina, Arabia Saudita, ma anche Egitto, Tunisia e Siria, fanno un uso autoritario della rete, ne filtrano l’informazione, ne sorvegliano le comunicazioni, la piegano a proprio beneficio per costruire consenso. Questo è tutto quello che pensavamo di sapere. Dal 2013, con le rivelazioni del whistleblower Edward Snowden, abbiamo la certezza che non soltanto i governi autoritari, ma anche quelli democratici come gli Stati Uniti controllino, sorveglino e spianino le comunicazioni globali.

La prima fase di Internet era piena di sogni confusi sulle potenzialità della comunicazione globale di cambiare la condizione umana e sulle possibilità mozzafiato di creare un “cervello del mondo” pieno di informazioni facilmente disponibili. All’inizio pochi commentarono le dimensioni irrealizzate della sorveglianza su Internet. Pochi sviluppi tecnologici – con l’eccezione della bomba atomica – hanno conseguenze negative assolute per l’umanità. Pertanto, distinguere una situazione distopica da una utopica è una sfida continua.

Il filosofo Michel Foucault, criticando il sogno democratico di Jean-Jacques Rousseau, avrebbe probabilmente disprezzato la visione utopica del web 2.0 e della sorveglianza digitale, di questa perenne esposizione. Egli diceva dell’utopia: “[Era il sogno] di una società trasparente, al tempo stesso visibile e leggibile in ciascuna delle sue parti; che non ci siano più zone oscure, zone regolate da privilegi del potere reale o dalle prerogative di questo o di quel corpo, o ancora del disordine”[2] .

Come sbagliata è anche la metafora del romanzo distopico di Orwell, 1984, per raccontare la nostra epoca; quello immaginato dallo scrittore britannico era un mondo grigio, opprimente e governato da dittature feroci. Per quanto la società di 1984 sia basata sulla sorveglianza, si tratta di sorveglianza “tradizionale”, da stato di polizia, in cui il controllo è solo dall’alto verso il basso: una sorveglianza che schiaccia e umilia.

Chiunque usi uno smartphone o una connessione internet sa che i suoi dati verranno tracciati, aggregati, misurati, scansionati e archiviati. Che piaccia o meno, tutti rivestiamo un ruolo nella sorveglianza. Per questo il sociologo David Lyon, nel suo ultimo libro La cultura della sorveglianza[3], non tratta più l’argomento con le nozioni di “stato” o “società”, bensì parla di cultura. I dati che creiamo usando Facebook (o qualsiasi altro social) vengono sì sfruttati dalle organizzazioni per venderci al miglior offerente, ma sono anche lo strumento che noi stessi utilizziamo per sorvegliare, de facto, ciò che i nostri amici dicono e fanno. Attraverso i dati, ci auto-sorvegliamo. Oggi, piuttosto, viviamo costantemente immersi in una condizione di sorveglianza che non è più solo top-to-bottom, ma è anche peer-to-peer. Google, Facebook e gli altri non sono basati sulla logica del big brother, ma su quella, per citare Antonio Casilli, del big other: sono gli altri, gli utilizzatori come noi, che contribuiscono alla nostra sorveglianza nel momento in cui condividono con noi i loro contenuti.

Il panorama di oggi, come vedremo, è molto più complesso rispetto alla dicotomia tra “noi” e “loro”, in cui loro guardano noi, invadendo la nostra privacy e violando i nostri diritti.

I rischi e le potenzialità di condizionamento che ne derivano sono esorbitanti. Pierazzuoli interviene allora sia per rimproverarci sia per avvisarci: la poca attenzione che finora vi abbiamo prestato ci ha inevitabilmente condotto in una spirale del silenzio dove, per esempio, proviamo disagio nell’esprimere un’opinione divergente rispetto alla massa, e ci rifugiamo in community online di nicchia dove una parvenza di anonimato ci fa sentire sicuri di esprimerci.

“Il dialogo fra cittadini su questioni pubbliche, che costituisce la trama della cosiddetta sfera pubblica, è ritenuto da autorevoli studiosi – fra cui il sociologo e filosofo Habermas – come una caratteristica fondante della democrazia moderna e contemporanea”[4]. Sfera pubblica è, infatti, la traduzione italiana del concetto habermasiano di “Öffentlichkeit”, inteso come uno spazio di incontro e argomentazione tra soggetti liberi, detenenti uguali diritti di parola, che affrontano problemi di interesse collettivo e sottopongono al vaglio intersoggettivo le loro idee-opinioni espresse attraverso forme argomentative.

La sfera pubblica, oggi, si riversa in quella vasta rete di elaboratori a estensione mondiale,

interconnessi in senso fisico e logico, chiamata Internet. Quel fenomeno che Habermas identificava nelle “English-coffee houses” si espande, da luogo fisico a luogo digitale, grazie appunto allo sviluppo delle reti. Ma, come sottolinea Pierazzuoli, la rete non è omogenea, piuttosto è fatta di condensazioni. Infatti, il dibattito mediatico è messo a dura prova da quel meccanismo soprannominato Filter Bubble o Echo Chamber. Entrambi i termini, con sfumature diverse, “fanno riferimento al fatto che sul web si creano degli spazi dove gli utenti tendono a condividere idee simili, facendosi eco l’un con l’altro, e rischiando di isolarsi intellettualmente nella propria bolla di informazioni”[5].

Internet tenderebbe così a valorizzare una componente psicologica dell’essere umano: l’omofilia, che corrisponde alla tendenza a frequentare persone simili a noi. Queste piattaforme sono interessate a fare in modo che si stia il più possibile nei propri ambienti informativi: per esempio, Facebook è interessata a far sì che vengano lette per quanto più tempo possibile le informazioni che propina, perché́ ciò̀ garantisce sì pubblicità, ma soprattutto più dati da poter rivendere o riutilizzare. Per riuscirci, dunque, offrono ciò̀ che attrae gli utenti, e lo fanno profilando ogni singolo individuo, aumentando così l’omofilia e l’effetto di “autoreferenzialità”.

Il lavoro delle Echo Chamber alimenta quel processo di disordine informativo per cui, in una società dell’apparenza, o sensazionalista, il digitale – secondo Eric Sadin – si erge a potenza aletheica. La ricerca dei pensatori greci, primi fra tutti Socrate e Platone, della verità assoluta (aletheia) contro il sofisma o verità apparente (doxa), diventa la protagonista dei nuovi dibattiti digitali. Come sottolinea Pierazzuoli, la funzione dell’algoritmo è quella di “trasformare la singola opinione tramite i like e la condivisione, in opinione da dover condividere (tutto il resto viene escluso), in definitiva in una forma di verità statistica che l’algoritmo fa sua”[6].

L’ambiguità non viene disvelata, è semplicemente tradotta in opinione condivisa. Ecco perché il sistema sopporta le fake-news: esso può trasformare le fake-news in verità. Anzi, in post-verità.

Termine nato nel 2016, quando l’Oxford Dictionary ha eletto post-truth parola dell’anno, è divenuto subito emblema di ciò che avviene in questa società digitalizzata. La post-verità, secondo McIntyre, è “una forma di supremazia ideologica, per la quale chi la sostiene cerca di costringere qualcuno a credere in qualcosa, che esistano o meno buone prove per crederci”[7]. Che le persone mentano, e che la politica usi la propaganda per perseguire i propri fini non è certo una novità. Per post-verità si intende però qualcosa di molto diverso: un contesto in cui l’ideologia ha la meglio sulla realtà, perché quale sia la verità interessa poco o niente. Quando si mente, si cerca di convincere qualcuno che quel che si sostiene è vero. Con la post-verità, tutto questo è irrilevante. Non occorre sforzarsi di ingannare nessuno. Non si devono costruire prove false. Quel che conta è avere la forza di imporre la propria versione, indipendentemente dai fatti. Basta ripetere concetti semplici e accattivanti, anche se infondati, perché a nessuno conviene verificarli.

Da qui una domanda cardine: se finora abbiamo prestato fede al principio di neutralità della rete, che impone ai provider di trattare allo stesso modo qualsiasi pacchetto (di tipo informativo, contenutistico, di piattaforma), possiamo ancora parlare – oggi – di imparzialità di Internet come logica realmente applicabile? Considerando che l’avanzamento tecnologico ci ha condotto ad un’esperienza-utente sempre più “comoda”, user-friendly e immediata, sembra utopistico pensare ad un’alternativa che ci offra democraticamente sia un’usabilità conveniente sia una totale imparzialità dei contenuti e dell’informazione. Consapevoli del fatto che il comfort digitale su cui ci siamo adagiati (traduttore automatico, correzione automatica, ranking personalizzato dei risultati, ecc.) ha un prezzo, e il prezzo sono i nostri dati, saremmo disposti a rinunciarvi in toto per salvaguardare la nostra privacy?

Da qui una domanda cardine: se finora abbiamo prestato fede al principio di neutralità della rete, che impone ai provider di trattare allo stesso modo qualsiasi pacchetto (di tipo informativo, contenutistico, di piattaforma), possiamo ancora parlare – oggi – di imparzialità di Internet come logica realmente applicabile? Considerando che l’avanzamento tecnologico ci ha condotto ad un’esperienza-utente sempre più “comoda”, user-friendly e immediata, sembra utopistico pensare ad un’alternativa che ci offra democraticamente sia un’usabilità conveniente sia una totale imparzialità dei contenuti e dell’informazione. Consapevoli del fatto che il comfort digitale su cui ci siamo adagiati (traduttore automatico, correzione automatica, ranking personalizzato dei risultati, ecc.) ha un prezzo, e il prezzo sono i nostri dati, saremmo disposti a rinunciarvi in toto per salvaguardare la nostra privacy?

Come l’autore spesso sottolinea, la gamification della società, del lavoro e del tempo libero è una prospettiva concreta, vicina. I francofortesi, già negli anni Quaranta del ‘900, studiavano l’atteggiamento dell’industria culturale globalizzata e l’influenza che i suoi prodotti avevano sui comportamenti e le abitudini umane. Oggi il sodalizio tra industria culturale e tecnologia è più forte che mai: tempo di lavoro e tempo libero sono ormai sovrapposti, non differenziabili; l’entertainment stesso è diventato lavoro. Casilli lo ha ben spiegato in relazione ai concetti di lavoro sociale in rete, playbor e hope labor: “[essi] si basano sulla partecipazione degli utenti dei social media come Facebook o Instagram. Si tratta di mansioni spesso assimilate al tempo libero, alla creatività o alla socialità. La produzione di contenuti, la loro condivisione, la dimensione relazionale di questa attività contribuiscono a decostruire le categorie di piacere e di fatica, di autonomia e di subordinazione, di scelta e di vincolo, o piuttosto a rendere la realtà delle seconde meno tangibile”[8].

L’urgenza frenetica e globale di connettere tutto e tutti, in ogni momento, sta silenziosamente dando vita a una nuova forma di socialismo. Infatti quando le masse, che sono in possesso dei mezzi di produzione, lavorano verso il raggiungimento di uno scopo comune e condividono i prodotti del proprio lavoro, quando lavorano senza paga e godono dei risultati senza pagare, non è irragionevole parlare di socialismo. Il data mining e quindi tutta l’attività degli utenti online sono stati interpretati come segnale di un nuovo capitalismo del prosuming. Un tipo di capitalismo che differisce dal vecchio, basato sulla produzione, e dal più recente, basato sul consumo. Il lean thinking è il cardine attorno a cui ruota la strategia di sfruttamento dettata dalla piattaforma, ovvero un tipo di management aziendale che mira a ridurre i costi di transazione e di occupazione, al fine di moltiplicare il valore di beni quali dati e informazioni[9]. Proprio grazie al loro ruolo di mere intermediarie, le piattaforme sono riuscite a sfruttare alcuni vuoti normativi relativi a tipologie contrattuali atipiche, cosa che gli ha consentito di privare i lavoratori delle tutele sociali previste dai classici contratti di lavoro subordinato[10].

Il potere normativo della gestione algoritmica riesce nel suo intento perché costruisce il consenso promuovendo un ideale iper-meritocratico di giustizia. Ecco che giungiamo a quelli che Pierazzuoli definisce algoritmi di tipo prescrittivo/coercitivo, ideati non per garantire la tutela dei lavoratori e il soddisfacimento degli utenti, ma esclusivamente per perseguire gli interessi della piattaforma, attraverso un accurato percorso di profilazione e valutazione: due “gabbie mentali che permeano l’universo sensibile del capitalismo digitale”[11].

La prospettiva futura che ne emerge, quindi, non sembra essere delle più promettenti. La recente pandemia, tramite processi di digitalizzazione della scuola, della cultura, della burocrazia, ha contribuito alla costruzione di una realtà sociale surrogata, paragonabile a una gelida smart city della sorveglianza, in cui tutto sarà previsto ed ottimizzato. L’algoritmo non tollererà̀ l’inefficienza umana, anzi aprirà la strada all’instaurazione di piani di discriminazione ed emarginazione sociale, in nome di una surrettizia sicurezza collettiva[12].

Che cos’è allora il soggetto collaborativo che dà il titolo all’opera? In questo cupo scenario distopico, Pierazzuoli individua un antidoto concettuale notevole. Nel contesto della forza lavoro, l’individuo “ibridato”, inteso come soggetto che incorpora sia parti biologiche – quindi degradabili – sia meccaniche, inalterabili, racchiude in sé un’intelligenza di tipo collaborativo. Non si tratta di una capacità artificiale, né di una caratteristica biologica, bensì di un’intelligenza diffusa, combinata. È dalla relazione tra intelligenza artificiale e organica che si scorge una via di fuga dal sistema di produzione e sfruttamento capitalistico. Le acute considerazioni dell’autore, ispirate quasi da una volontà di superamento della prospettiva marxista, offrono così un solido terreno di riflessione sul tema dell’intelligenza artificiale applicata all’ambito lavorativo. Tuttavia, nonostante più volte nel corso dell’opera Pierazzuoli chiarifichi la sua posizione non luddista, le sue conclusioni appaiono venate da un leggero pessimismo tecnologico, e ancora molto legate a un contesto filosofico e ideologico che poco considera gli escamotages pratici che già abbiamo di fronte.

Anche Ingrid Paoletti, nel libro Siate materialisti![13], parte da osservazioni affini: la potenza di calcolo e previsione che gli algoritmi oggi ci offrono non ha eguali e ci ha permesso di far evolvere la nostra percezione del reale, a favore di una ridefinizione delle categorie di oggettività e soggettività[14]. Per certi versi, tuttavia, il materialismo non va demonizzato, ma sfruttato positivamente: il potere computazionale è legato imprescindibilmente allo sviluppo della società[15]. E allora occorre ripensarla in termini algoretici[16].

Gli algoritmi vengono spesso visti come apolitici, tecnocratici e privi di valore; ma, in termini pratici, ci offrono parecchi vantaggi. Come evidenzia Paoletti, tecnologie come la blockchain offrono soluzioni distribuite, trasparenti e autonome, applicabili ai più svariati ambiti del digitale in senso open source. Sono atti fondamentalmente etici. È arrivato il momento di pensare filosoficamente il software per non ritrovarsi schiavi di oracoli pronunciati da nuovi dèi fatti di silicio”[17].

Paolo Benanti – francescano del Terzo Ordine Regolare e teologo, nonché studioso di etica delle tecnologie – sottolinea come il risultato più soddisfacente dei Big Data stia nella capacità di raccogliere informazioni eterogenee e di individuare relazioni, collegamenti e connessioni inaspettate. “Le aspettative sono elevatissime e molte aziende sono impegnate nella costruzione di questo grande oracolo personale (…) La vera sfida è far parlare questo nuovo oracolo digitale, capire cosa ci dice. Ci sembra una curiosa coincidenza che una delle maggiori società leader nella catalogazione dei dati e negli strumenti per studiare e gestire i database si chiami Oracle, cioè oracolo”[18].

Paolo Benanti – francescano del Terzo Ordine Regolare e teologo, nonché studioso di etica delle tecnologie – sottolinea come il risultato più soddisfacente dei Big Data stia nella capacità di raccogliere informazioni eterogenee e di individuare relazioni, collegamenti e connessioni inaspettate. “Le aspettative sono elevatissime e molte aziende sono impegnate nella costruzione di questo grande oracolo personale (…) La vera sfida è far parlare questo nuovo oracolo digitale, capire cosa ci dice. Ci sembra una curiosa coincidenza che una delle maggiori società leader nella catalogazione dei dati e negli strumenti per studiare e gestire i database si chiami Oracle, cioè oracolo”[18].

Sono gli algoritmi che determinano le linee di condotta dei robot, ma, in un ambiente misto, dove il partner lavorativo è quello umano, la policy deve essere adeguata; il robot deve così interagire col soggetto in maniera rispettosa, deve guardare ai propri fini rispettando la dignità della persona e capire le modalità più appropriate da adottare per il raggiungimento del suo scopo. La priorità operativa è dell’individuo, non dell’algoritmo.

Un articolo di Wu Ming 2 del 2008 è la sintesi perfetta della dicotomia tra la classe hacker, quella dei lavoratori/produttori dell’informazione, e gli oligarchi informatici interpreti di una nuova forma di capitalismo: “Solito vecchio discorso: poiché il nemico utilizza uno strumento, lo strumento diventa il nemico. Qualcun altro, per fortuna, ci ha insegnato che le macchine vanno strappate a chi le controlla e usate per contrastare il dominio”.

________________________________________________

- G. Pierazzuoli, Il soggetto collaborativo. Per una critica del capitalismo digitale, Ombre Corte, 2022, p. 22. ↑

- P. Di Salvo, Leaks. Whistleblowing e hacking nell’età senza segreti, Luiss University Press, 2019, pg. 155 ↑

- D. Lyon, La cultura della sorveglianza. Come la società del controllo ci ha resi tutti controllori, LUISSINTEMPO, 2020 ↑

- G. Giacomini, Potere Digitale: come Internet sta cambiando la sfera pubblica e la democrazia, Maltemi, 2018, pg. 21 ↑

- Ibidem, pg. 67 ↑

- G. Pierazzuoli, Il soggetto collaborativo. Per una critica del capitalismo digitale, Ombre Corte, 2022, p. 29 ↑

- L. McIntyre, Post Verità, UTET università, 2019, pg.17 ↑

- A. Casilli, Schiavi del clic, Feltrinelli, 2020, p. 137. ↑

- N. Srnicek, Platform capitalism, Polity Press, 2016, p.32. ↑

- G. Pirina, Capitalismo delle piattaforme e materialità sociale. Degradazione del lavoro e della natura lungo la filiera del coltan, Culture della Sostenibilità 25, 2020, p. 13 ↑

- G. Pierazzuoli, Il soggetto collaborativo. Per una critica del capitalismo digitale, Ombre Corte, 2022, p. 69. ↑

- Op. cit., Pierazzuoli, p. 56 ↑

- I. Paoletti, Siate materialisti!, Einaudi, 2021. ↑

- Ibidem, pg. 29 ↑

- M. Durante, Potere computazionale. L’impatto delle ICT su diritto, società e sapere, Meltemi, 2019, p.11 cit. in Paoletti, 2021 ↑

- Studio dei problemi e dei risvolti etici connessi all’applicazione degli algoritmi. ↑

- P. Benanti, Oracoli. Tra algoretica e algocrazia, Collassi, 2018, pg. 74 ↑

- Ibidem, pg. 77 ↑

Gilberto Pierazzuoli, Il soggetto collaborativo. Per una critica del capitalismo digitale, ombre corte, Verona 2022, pp. 254, € 22.00

Ci sono molti punti sui quali dissento, rispondo però soltanto dove le autrici fanno riferimento direttamente alla mia persona e dove dicono: “le sue conclusioni appaiono venate da un leggero pessimismo tecnologico, e ancora molto legate a un contesto filosofico e ideologico che poco considera gli escamotages pratici che già abbiamo di fronte”. È una dichiarazione che sembra dire che conoscendo i trucchetti per utilizzarla essa sia a prescindere una tecnologia positiva. Quali? Se è vero quello che si dice appena sopra non si tratta di trovare escamotages all’interno del sistema ma di costruire un altro sistema utilizzando anche alcune di quelle tecnologie. Bernard Stiegler e Yuk Hui. Il racconto sull’esperienza cibernetica cilena, le idee su una teoria della complessità che mette al centro un’episteme collaborativa come la tectologia di Bogdanov. La descrizione delle nuove forme di capitalismo raccontate da Mackenzie Wark. La differenza profonda tra IoT e OOO (internet delle cose e ontologia orientata agli oggetti). L’accelerazionismo di sinistra con l’intervento di Negri nella pubblicazione collettanea a cura di Matteo Pasquinelli. La ridefinizione delle catene del valore che impone l’ipotesi della piena automazione. E qui mi taccio